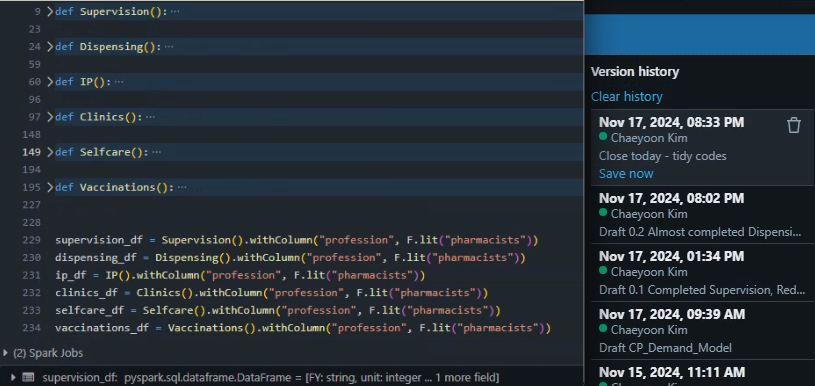

디펜던시가 있어 차선책으로 마련해둔 브랜치가 있었다. 데이터 릴레이만 확인하려고 골든 모델 아웃풋 B를 저장한 것을 불러온 다음 기존 모델 아웃풋 A에 유니언 시키는 간단한 내용이다. A가 B보다 데이터 레벨이 낮다. Aggregation이후 Union하는건 코드 몇 줄로 끝나는 간단한 작업이지만, 오랜시간 협의가 필요했던 이유는 데이터 레벨이 가장 높은 디펜던시 C가 A와 B 사이에 와야했기 때문이다. 초안 A -> 1st agg -> 2nd agg -> C (merge) B ------------> 2nd agg ------/ 협의사항은 C의 설계를 바꾸어 데이터는 앞에서 모두 병합한 상태로 받되 B를 필터하고 바이패스할 수 있도록 로직 추가를 하는 일이다. 2안 A -> 1st agg (merge)..